In den letzten Monaten hat sich der Begriff „RAG“ (kurz für „Retrieval Augmented Generation“) im Zusammenhang mit der Erstellung von Chatbots und KI-Assistenten rapide ausgebreitet. In diesem Blogbeitrag beschreiben wir:

- Wie RAG funktioniert

- Warum die Methode tatsächlich einen Durchbruch darstellt

- Welche Grenzen RAG aktuell noch gesetzt sind

Generative KI ist ohne RAG in Unternehmen nicht einsetzbar

Nach der Veröffentlichung von ChatGPT vor etwas mehr als einem Jahr ist schnell klar geworden, dass Large Language Models (LLMs) wie ChatGPT nur ein begrenztes Wissen aus ihren Trainingsdaten mitbringen und dazu neigen, ihre Aussagen auszuschmücken und sogar Informationen frei zu erfinden. Man spricht davon, dass sie dazu neigen, zu „halluzinieren“. Deshalb sind LLMs in ihrer Rohform nicht für Einsätze geeignet, in denen es auf die Korrektheit von Informationen oder auf Formulierungen in einem speziell gewünschten Sinn ankommt. Um es ganz einfach zu sagen:

“ChatGPT allein ist für den Einsatz in Unternehmen nicht geeignet.”

Was aber, wenn man ein LLM dazu bringen kann, sich bei der Beantwortung von Fragen auf aktuelle und kuratierte Informationen zu stützen? Als Unternehmen möchte man vor allem das Sprachverständnis und die Ausdrucksmöglichkeiten der generativen KI nutzen, die Wissensbasis hingegen möchte man selbst zur Verfügung stellen. Genau dies ist das Prinzip der Retrieval Augmented Generation, abgekürzt RAG. Es handelt sich um eine Methode, die erstmals 2020 in einem Paper mit dem Titel „Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks“ (Lewis et al.) erwähnt wurde und die in kurzer Zeit zum neuen Standard der Informationsverarbeitung in Unternehmen geworden ist.

Wie funktioniert RAG?

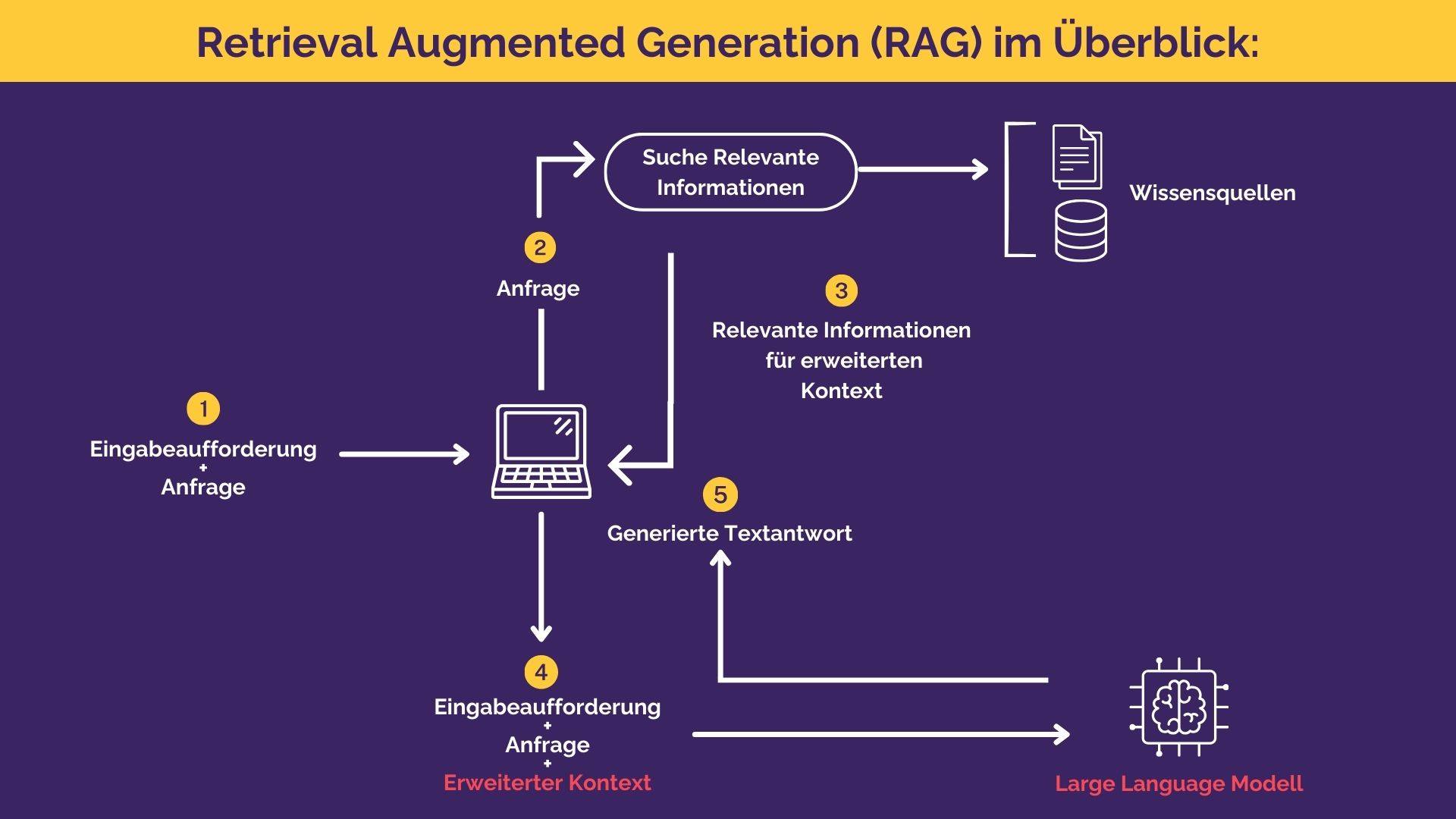

Wie der Name nahelegt, arbeitet RAG in zwei Schritten: Informationssuche (Retrieval) und Antwortgenerierung.

- Um eine Nutzeranfrage zu beantworten, sucht das System zunächst nach relevanten Informationen. Diese können aus verschiedenen Quellen stammen, z.B. von Webseiten, aus wissenschaftlichen Artikeln oder aus Datenbanken.

- Anschließend nutzt das Modell diese abgerufenen Informationen, um eine präzise und kontextbezogene Antwort zu generieren.

Die folgende Abbildung zeigt das Prinzip.

Bessere Chatbots: Einsatz von LLM’s und RAG in Kombination

Die Verwendung von RAG hat mehrere Vorteile gegenüber dem Einsatz von LLMs ohne Retrieval-Komponente:

- RAG verbessert die Genauigkeit und Zuverlässigkeit von Chatbot-Antworten. Indem es spezifische Informationen zu einer Anfrage liefert, reduziert es die Wahrscheinlichkeit von irrelevanten oder falschen Antworten.

- Es ermöglicht eine deutlich größere Aktualität der Antworten. Durch den Abruf aktueller Informationen kann RAG auf Ereignisse oder Inhalte eingehen, die erst nach dem letzten Training des Modells aufgetreten sind.

- RAG fördert eine effiziente Informationsnutzung, da es direkt auf eine umfangreiche Datenquelle zugreift, anstatt sich ausschließlich auf das zu verlassen, was im Modell bereits vorhanden ist.

Aufgrund dieser Vorteile hat RAG sich schnell als Schlüsseltechnologie für den Einsatz von Chatbots im Unternehmenskontext etabliert.

Die aktuellen Limitationen von RAG

Trotz dieser Vorteile ist die Entwicklung eines Chatbots mit der RAG-Methodik kein Selbstgänger. Zum einen spielen die Qualität und Aktualität der Datenbanken, aus denen Informationen abgerufen werden, eine große Rolle für die Qualität der Antworten. Veraltete oder ungenaue Daten können zu irreführenden Antworten führen. Auch hier gilt das alte Prinzip der Datenverarbeitung „garbage in, garbage out.“ Zum anderen kommt bei diesem Verfahren dem Retrieval-Schritt eine fast noch wichtigere Rolle zu als dem Generation-Schritt. Wenn im ersten Schritt nicht die richtigen Informationen gefunden werden, kann im zweiten Schritt auch keine gute Antwort generiert werden. Damit spielt die Optimierung der Informationssuche nach wie vor eine bedeutende Rolle bei der Entwicklung von Chatbots oder KI-Assistenten. Bei Kauz haben wir auf diese Herausforderungen reagiert, indem wir die RAG-Methodik einerseits weiter optimieren, andererseits gezielt mit klassischer regelbasierter NLU ergänzen. Auf die damit verbundenen Herausforderungen und mögliche Lösungen gehen wir in einem zweiten Teil dieser Artikelserie ein.

RAG ist ein Durchbruch, aber kein Selbstträger

RAG markiert einen Durchbruch in der Entwicklung von Chatbots und künstlicher Intelligenz. Durch die geschickte Kombination von Informationssuche und Generierung ermöglicht RAG die Erstellung qualitativ hochwertiger Systeme in kurzer Zeit. Dennoch werden klassische Aufgaben wie Auswahl und Pflege der Wissensbasis, Optimierung von Suchalgorithmen und ggfs. Annotation von Daten dadurch nicht gänzlich überflüssig, sondern machen den Unterschied zwischen einem mittelmäßigen und einem wirklich guten System aus.